AI超算力服务器当下最大难题是什么?

2025-12-12(363)次浏览

在当下AI技术迅猛发展的背景下,AI超算力服务器(即用于大模型训练与推理的高性能计算集群)虽然成为推动人工智能进步的核心基础设施,但其部署和运行过程中正面临一系列严峻且复杂的难题。这些挑战不仅涉及硬件层面,还延伸至能源、散热、网络、软件生态乃至供应链安全等多个维度。以下是当前AI超算力服务器面临的主要难题:

1. 功耗与能效瓶颈:电力成为“新石油”

单机柜功耗飙升:传统数据中心机柜功率约5–10kW,而AI训练机柜已普遍突破50–100kW,部分前沿系统(如英伟达GB200 NVL72)甚至逼近300kW/柜。

供电能力不足:多数现有数据中心单栋楼供电上限仅10–20MW,而一个万卡级AI集群可能需数百兆瓦电力,远超基础设施承载能力。PUE压力增大:高功耗推高整体能耗,若冷却效率不足,PUE(电源使用效率)将恶化,违背“双碳”目标。

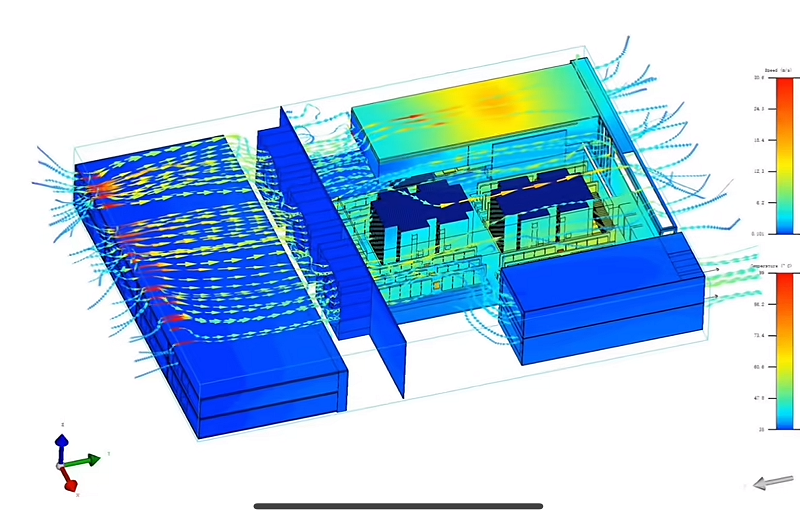

2. 散热极限:风冷已到天花板,液冷尚未普及

芯片热密度激增:GPU/AI芯片单位面积发热量已达1kW/cm²以上,远超传统CPU。风冷逼近物理极限:空气导热效率低,难以应对高密度部署下的局部热点。

液冷技术门槛高:浸没式/冷板式液冷需重构机房架构;快换接头、冷却液、密封性等关键部件存在供应链瓶颈(如快换接头专利垄断);运维复杂度高,故障风险上升。

现实困境:液冷虽是趋势,但成本高、标准不统一、改造难,导致大量存量数据中心“想转却转不动”。

3. 通信瓶颈:节点间互联成性能“拦路虎”

大模型训练依赖千卡级协同,但传统以太网或InfiniBand在超大规模下延迟高、带宽不足。“通信墙”问题凸显:当算力提升时,数据搬运速度跟不上,GPU大量时间处于“等待”状态,资源利用率骤降。国产方案虽推出自研高速互联协议(如华为“灵衢”、阿里EIC/MOC),但在生态兼容性、跨厂商互通方面仍处早期。

核心矛盾:算力可堆,但“连接”难扩——系统效率≠单卡性能之和。

4. 国产化替代与生态割裂

受地缘政治影响,高端GPU(如A100/H100)受限,国产AI芯片(昇腾、寒武纪、天数等)加速上量。但软硬件生态不成熟:框架适配(PyTorch/TensorFlow对国产芯片支持弱);编译器、驱动、工具链碎片化;芯片与服务器、调度系统、存储之间缺乏深度协同。“芯片造出来了,但跑不快、用不好”成为普遍痛点。

挑战本质:算力自主 ≠ 算力可用,生态整合比芯片制造更难。

5. 可靠性与运维复杂度剧增

千卡集群中,任意一块芯片或网络故障都可能导致训练任务中断,损失数百万美元算力成本。传统容错机制(如Checkpoint)在超大规模下效率低下,恢复时间长达数小时。需要秒级故障隔离、断点续训、智能调度等高级能力,对系统软件提出极高要求。

隐性成本:稳定性不足将直接抵消算力投入的回报。

6. 成本高企,中小企业难以入场

一套万卡级AI集群建设成本可达数十亿人民币;不仅包括硬件,还包括电力改造、液冷基建、运维团队等隐性支出;导致AI算力资源高度集中于头部云厂商与国家队,普惠AI仍遥远。

现实鸿沟:算力民主化口号响亮,但“算力贵族化”趋势加剧。

结语:破局需系统性创新

AI超算力服务器的难题,已不再是单一技术问题,而是涵盖“电、热、网、芯、软、标、安”七大维度的系统工程。未来破局方向包括:

推广液冷+高压直流供电一体化设计;发展光互联、硅光封装降低通信延迟;构建开放的国产AI算力生态(如中科曙光ScaleX开放架构);推动超节点级调度与容错技术;制定AIDC(AI数据中心)国家标准,引导平滑演进。唯有通过硬件革新 + 软件协同 + 基建升级 + 生态共建的多轮驱动,才能真正释放AI算力的全部潜能,让“智能水电煤”真正流动起来。

最新资讯

-

28080散热风扇改善储能设备散热问题提升可靠性

储能设备在夏天遇到散热不足问题导致设备工作不问题,重新调整28...

-

高效散热,稳定守护——东兴岳25489交流散热风扇在UPS柜顶部安装的应用实践

对日益增长的电力密度与可靠性要求,UPS系统的热管理已从“辅助...

-

从热管理看可靠性:电池化成设备中散热风扇的实战价值

在锂电池制造过程中,化成是决定电池性能、安全性和寿命的关键环...

-

超聚变服务器散热方案

在高密度计算与存储需求激增的今天,超聚变(FusionServer)服务...

0755-29555842

联系电话:18924583791

公司传真:0755-29555832

公司邮箱:sales@dxymotors.com

公司地址:广东省深圳市龙华新区大浪街道部九窝龙军工业区A18栋二层 | 供应商热线:0755-29555842-804

0755-29555842

0755-29555842